Maschinenlesbar, gut dokumentiert und mit klarer Lizenz – so mögen die Datenjournalisten Götz Gringmuth, Kira Schacht und Dominik Wurnig wissenschaftliche Datensätze. Im Rundfunk Berlin-Brandenburg (RBB) erzählen sie Geschichten auf Datenbasis. Wir haben sie gefragt, wie Forscher und Pressestellen ihnen die Recherche erleichtern können.

Wissenschaftliche Daten, die Geschichten erzählen

Frau Schacht, Herr Gringmuth, Herr Wurnig, welche wissenschaftlichen Daten bieten sich für journalistische Geschichten an?

Kira Schacht: Im Prinzip alle. Das ist das Schöne an Datenjournalismus. Daten gibt es zu allen möglichen Themen und es hängt dann von journalistischen Kriterien ab, ob ein Thema relevant und aktuell ist.

Götz Gringmuth: Und davon, ob wir es schaffen, dazu eine Geschichte zu erzählen. Datenjournalismus besteht nicht nur aus bunten Infografiken. Wir arbeiten ja auch für Radio und Fernsehen. Da stellen Zahlen eine besondere Herausforderung dar. Jeder kennt das von sich selbst: Spätestens nach der dritten Zahl hört man weg. Wenn eine gute Geschichte hinter den Daten steckt, kann man die aber auch im Radio erzählen.

Schacht: In der Studie Datenjournalismus in Deutschland von 2014 kommen Weinacht und Spiller zu einer sehr schönen Definition. Demnach hat Datenjournalismus drei Komponenten: die datengetriebene Recherche, eine spezifische, fast wissenschaftliche Art und Weise, diese Daten zu interpretieren und Datenvisualisierungen als Darstellungsform. Als Datenjournalisten suchen wir also nach Geschichten in Daten. Wie wir sie am Ende erzählen, ist von Fall zu Fall unterschiedlich.

Haben Sie ein Beispiel für eine gute Wissenschaftsgeschichte im Datenjournalismus?

Dominik Wurnig: Wir haben eine Recherche gemacht, die dann unter dem Titel „Abgas Alarm“ in verschiedenen RBB-Medien gelaufen ist. Dafür haben wir gemeinsam mit der Technischen Universität Berlin an 100 Standorten der Stadt gemessen, wie hoch die Stickoxidbelastung ist. Das ist eine Geschichte, weil unter anderem in der Politik aktuell über Fahrverbote diskutiert wird, da bestimmte Grenzwerte überschritten werden. Dank unserer Datenvisualisierung können die Berliner jetzt sehen und nachvollziehen, wie die Belastung in ihrer direkten Umgebung ist.

Wie können Universitäten und Institutionen ihre Datensätze zugänglich machen, um die Recherche zu erleichtern?

Wurnig: Open-Data-Portale sind etabliert und bekannt. Da kann man die Daten einfach bereitstellen und wir entscheiden dann selbst, welche wir brauchen.

Schacht: Die meisten größeren Städte und Regionen haben Datenportale, das Statistische Bundesamt oder GovData für Verwaltungsdaten stellen auch Daten zur Verfügung, aber bei den Unis ist es schwer, an wissenschaftliche Daten zu kommen. Da muss man oft viel telefonieren und Überzeugungsarbeit leisten. Bei Wissenschaftsthemen ist es auch schon passiert, dass Forscher sich nach der Berichterstattung melden und schreiben, dass sie gerade auch zu dem Thema arbeiten. Da ist es dann natürlich schade, dass man sie nicht vorher gefunden hat. Ein gemeinsames Datenportal der Universitäten oder ein übergreifendes Datenportal für Forschungsdaten wäre also ein Traum.

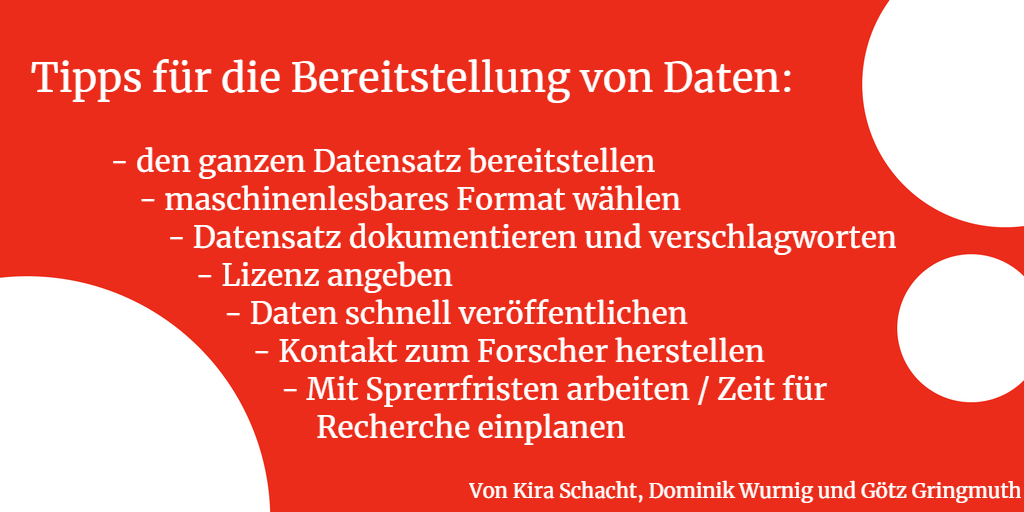

Gringmuth: Hier wäre dann auch wichtig, dass diese Daten gut dokumentiert, gut durchsuchbar und moderiert sind. Eine sinnvolle Verschlagwortung und Beschreibung erleichtert es uns sehr zu verstehen, um welche Daten es sich genau handelt.

Wurnig: Super ist auch, wenn die Lizenzierung direkt angegeben ist, also dabei steht, was man mit den Daten genau machen darf. Und hier auch noch mal die Einladung an Pressesprecher und Universitäten: Pitcht uns gerne auch komplexere und tiefer gehende Datensätze, die an den Forschungseinrichtungen erhoben werden – per E-Mail oder auch als Pressemitteilung.

Ist das der Weg, wie Sie Geschichten finden? Noch klassisch über Pressemitteilungen?

Schacht: Ja, das ist ein Weg und ein guter Kommunikationskanal. Ich würde mich dann aber freuen, wenn ich in der Pressemitteilung direkt einen Link zum Datensatz finde und eine Erläuterung, was für Daten er genau enthält.

Gringmuth: Wichtig ist auch, dass wir den ganzen Datensatz bekommen. Pressestellen von Ämtern oder Universitäten neigen dazu, Daten schon auszuwerten und ihre Sicht der Dinge in einer Pressemitteilung darzustellen. Was wir aber brauchen, sind die Rohdaten. Wenn wir eine Geschichte geliefert kriegen, bei der ein Satz von 5.000 Daten dahinter steckt und uns werden die Top 3 präsentiert, fragen wir immer nach den 5.000.

Wurnig: Außerdem ist es hilfreich, wenn wir die Daten schon ein paar Tage vorher bekommen können. Im Gegensatz zu den schreibenden Kollegen brauchen wir im multimedialen Bereich ein bisschen länger. Wenn also eine große Erkenntnis bei einer Pressekonferenz bekannt gegeben wird, zum Beispiel ein Durchbruch in der Krebsforschung, dann kann man hier gut mit Sperrfristen arbeiten.

Gringmuth: Wir halten uns dann auch daran. Je nachdem was wir erzählen wollen und ob wir die Inhalte auch für das Fernsehen aufbereiten, brauchen wir einfach mehr als einen Tag.

Sie hätten also gerne den kompletten Datensatz, gut dokumentiert, mit Lizenzangabe und gerne auch ein paar Tage vor der Veröffentlichung, weil Datenjournalismus Vorlauf braucht. Was würden Sie noch auf die Liste bei Wünsch-dir-was an wissenschaftliche Daten setzen?

Wurnig: Ein wichtiger Punkt, der vor allem Wissenschaftsthemen betrifft, ist Aktualität. Daran scheitert es oft, weil für uns im Januar 2018 die Daten aus dem Jahr 2016 eigentlich schon zu alt sind. So lange braucht es aber oft, bis ein Paper erscheint. Am liebsten hätten wir Daten von heute oder spätestens gestern. Je schneller die Forschenden also mit dem Datensatz rausgehen, desto besser.

Schacht: Außerdem ist eine gute Dokumentation des Datensatzes sehr wichtig. Das heißt: Eine schöne Erläuterung, was die einzelnen Spalten bedeuten. Ein direkter Kontakt zu der Person, die die Daten erhoben und ausgewertet hat, ist auch sehr gut. Das ist dann nicht unbedingt nur der Lehrstuhlinhaber, sondern vielleicht auch ein Doktorand oder Masterstudent. Und ein dritter Wunsch: Die Daten sollten maschinenlesbar sein.

Was bedeutet das genau?

Wurnig: Bitte keine PDFs und keine Texte. Wenn in der Pressemitteilung steht: „Die Werte sind im Vergleich zum Vorjahr um 5 Prozent gestiegen“, ist das nicht maschinenlesbar. Noch schlimmer sind ausgedruckte und eingescannte Papiere. Das gibt es zum Beispiel bei Nebeneinkünften von Parlamentsabgeordneten immer wieder und die müsste man dann einzeln abtippen. Eine Mindestanforderung ist also, dass man die Daten gut copy-pasten kann.

Gringmuth: Gehen wir mal in die Feinheiten: Ämter machen mich wahnsinnig damit, dass sie Excel-Tabellen erstellen, die keine eindeutigen Spalten haben. Zum Beispiel wenn ein Spaltenkopf über vier Spalten geht, dann noch eine weitere Zeile folgt, die zwei Spalten zusammenfasst, und so weiter. Damit wir eine Tabelle mit bestimmten Visualisierungsprogrammen verarbeiten können, brauchen wir einzelne Spalten, die nur eine Überschrift haben.

Schacht: Wissenschaftler sind da aber eher schon an unserer Denke dran, als zum Beispiel Ämter. Sie nutzen ähnliche Programme oder Programmiersprachen, um die Daten zu verarbeiten oder zu visualisieren. Das hat dann den Vorteil, dass sie uns die Daten direkt so weitergeben können, wie sie sie selbst auch verarbeiten. CSV- oder Excel-Tabellen sind uns da sehr recht.

Wurnig: Bei großen Datensätzen hilft auch eine API, also eine Programmierschnittstelle, sehr weiter. Das wäre dann der Gold-Standard.

Und mit welchen Programmen verarbeiten Sie die Daten dann weiter, wenn Sie visualisieren?

Gringmuth: Zum Beispiel mit DataWrapper, ein sehr einfaches Online-Tool, in das man Daten als CSV- oder Excel-Datei einspeisen kann. Damit kann man Daten in verschiedenen Formen visualisieren, zum Beispiel als Karten, Balken- oder Tortendiagramm.

Wurnig: Der große Vorteil ist hier, dass man die Visualisierungen direkt in eine Homepage einbetten kann und sie dort auch interaktiv, responsiv und so weiter sind.

Schacht: Wenn es mal komplexer wird, programmieren viele Datenjournalisten auch selbst. Ich verarbeite Daten zur Analyse auch in der Programmiersprache R. Je nach Sparte kennen Wissenschaftler das Programm, vor allem die Statistiker. Damit kann man so ziemlich alles machen, auch Visualisierungen.

Übersicht über maschinenlesbare Dateiformate beim Projekt Projekt Open Government Data Sachsen

Hintergründe zu Programmierschnittstellen (API) bei Chip.de

Open Data Handbook der Open Knowledge Foundation Deutschland

Einführung in die Programmiersprache R der Technischen Universität Dresden

Open Data Portale in Deutschland und International bei Offene Daten Wuppertal

Informationen zur Veröffentlichung von Forschungsdaten auf Forschungsdaten.info der Universität Konstanz

Übersicht über Lizenzen zur Veröffentlichung bei Berlin Open Data