Erklärbare künstliche Intelligenz (Explainable AI) ist ein Ansatz, der Menschen ermöglicht, die Ergebnisse von Machine-Learning-Prozessen zu verstehen. Ein Gespräch mit der Leiterin des „AI & Society Lab“ Theresa Züger über das Konzept und darüber, was eine gute Erklärung ausmacht.

„Keine handelnde Person, sondern eine Maschine“

Frau Züger, was steckt hinter dem Konzept „Explainable AI“?

„Explainable AI“ ist ein technischer Überbegriff, der aus der Informatik kommt. Dabei geht es darum, KI-Systeme besser zu verstehen. Explainable AI oder XAI hilft dabei zu prüfen, ob ein System technisch auch wirklich die Aufgabe löst, die wir ihm gegeben haben. Die Erklärungen sind noch nicht allgemeinverständlich, sondern decken vor allem für technische Expert*innen die speziellen Prozesse auf, die beispielsweise innerhalb eines neuronalen Netzes passieren. Diejenigen, die ein solches System aufsetzen, können nicht ganz genau sagen, was darin vor sich geht. Bei „Explainable AI“ nähert man sich dem durch mathematische Methoden.

Künstliche Intelligenz wird deshalb oft als Blackbox bezeichnet. Ist es möglich, die Vorgänge vollumfänglich zu erklären?

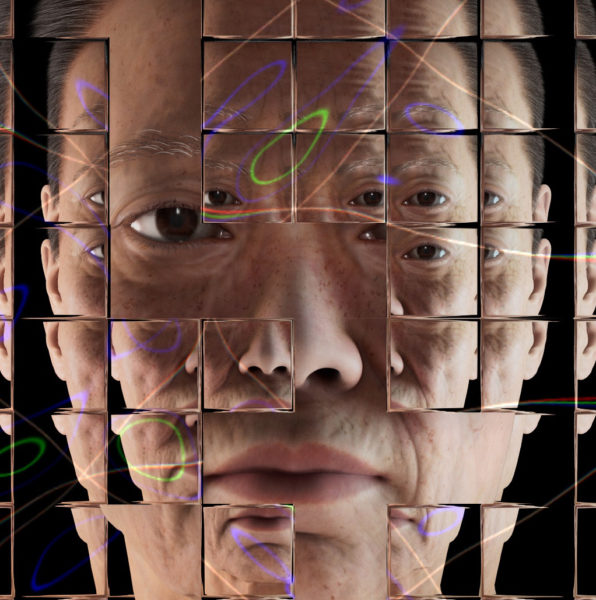

Der KI-Begriff umfasst unterschiedliche Technologien. Bei neuronalen Netzen können wir beispielsweise sagen, auf welchen Daten ein KI-Training basiert oder welche Parameter angewandt wurden. Die mathematischen Prozesse, die innerhalb dieses Netzes passieren, können wir aber nicht genau benennen. Ein bekanntes Beispiel für eine XAI Methode, die uns hilft neuronale Netze besser zu verstehen sind Heat Maps. Dabei findet das neuronale Netz – und jetzt vermenschliche ich es, weil es schwer ist, das anders auszudrücken – Bereiche eines Bildes, die relevanter für die Mustererkennung sind. Heatmaps können zum Beispiel aufdecken, wenn ein neuronales Netz sich auf ein Muster fokussiert, um das es gar nicht geht. Das Netz findet natürlich gar nichts – wie es ein Mensch tun würde –, sondern es ist eine Maschine. Aber manchmal fehlen uns leider die Worte, das gut zu umschreiben. Deswegen diese Vermenschlichung. Rein technisch ist es ein Auswertungsfokus, den das neuronale Netz setzt, den wir durch Heat Maps veranschaulichen und hervorheben können. Es ist also eine visuelle Darstellung auf Basis eines mathematischen Verfahrens. Aber eine gute allgemeinverständliche Erklärung ist das noch nicht.

An wen richtet sich dann „Explainable AI“?

Die Erklärungen, die im Moment für KI angefertigt werden, richten sich an zwei Zielgruppen: die Entwickler*innen, die diese Systeme bauen, und Expert*innen, die sie wiederum in einem bestimmten Kontext anwenden. Das können zum Beispiel Menschen in einer Bank oder im medizinischen Bereich sein, die verstehen müssen, auf Basis welcher Muster die KI-Systeme zu einer Empfehlung kommen. Sie geben immer nur Wahrscheinlichkeiten und keine finalen Ergebnisse an.

Für die Endnutzer*innen oder für normale Bürger*innen gibt es allerdings noch keine Modelle, die das in eine nachvollziehbare Erklärung übersetzen. Wir am Institut für Internet und Gesellschaftsforschung stellen uns deshalb die Frage, wie wir komplexe Systeme auch für Bürger*innen verständlich machen können. In unsere Forschung fließen verschiedene kommunikationswissenschaftliche Erkenntnisse ein, beispielsweise wie Menschen eigentlich komplexe technische Systeme verstehen und wie diese Dinge erklärt werden müssen, damit Bürger*innen bewusste Entscheidungen im Umgang mit diesen Systemen fällen können.

Was macht eine gute Erklärung aus?

Pauschal kann man das schwierig beantworten. Wichtig ist erst einmal, dass die Erklärung auf die jeweilige Zielgruppe und Situation zugeschnitten ist. Und das kann eben sehr Unterschiedliches bedeuten. Es gibt die Unterscheidung zwischen einer lokalen und einer globalen Erklärung von KI-Systemen: Lokal bedeutet, dass ich eine konkrete Entscheidung, global, dass ich das ganze KI-System ein Stück weit erklärt bekomme. Je nach Anwendungskontext ist eher das eine oder das andere relevant. In manchen Situationen muss man ganz schnell etwas verstehen, in anderen Fällen habe ich Zeit, mir Dinge im Detail anzugucken.

Wenn ich beispielsweise in einem autonomen Fahrzeug sitze und schnell eingreifen muss, möchte ich nicht das komplette System verstehen müssen und jedes Detail über die Technologie erklärt bekommen, sondern brauche in dem Moment die verständliche Information, um handlungsfähig zu sein und eine konkrete Entscheidung treffen zu können.

Neuronales Netz, Maschinelles Lernen

Neuronales Netz:

Mathematisches Konzept, bei dem Information auf verschiedenen Ebenen verarbeitet werden – vom einfachen Muster hin zu komplexen Strukturen.

Machine Learning (Maschinelles Lernen):

Mathematische Verfahren zur Mustererkennung.

Welche Akteur*innen sehen Sie in der Pflicht, kontext- und zielgruppenspezifisch über die Anwendungsfelder und die damit verbundenen ethischen Fragestellungen von künstlicher Intelligenz aufzuklären?

Das sind verschiedene Akteur*innen: Es tut sich viel in der Informatik, um Systeme erst einmal technisch besser erklären zu können. Dann braucht es Personen und Institutionen, die dieses Wissen wiederum für Bürger*innen und Anwender*innen übersetzen. Das können andere wissenschaftliche Akteur*innen, aber auch zivilgesellschaftliche Akteur*innen sein, die sich mit einem bestimmten Anwendungsfall auseinandersetzen und eine Art Advokat*innenrolle für Bürger*innen einnehmen.

Dazu zähle ich auch Journalist*innen, die in der Demokratie eine wichtige, vermittelnde Rolle haben, damit Bürger*innen eine informierte Entscheidung treffen können. Das hat auch mit Marktmacht und der Regulierung von Technologieunternehmen zu tun. Die Politik ist gefragt, einen Regulierungsrahmen zu setzen, der eben fordert, dass diese Übersetzungsleistung erbracht werden muss, zumindest in bestimmten Fällen. Dabei kommt es auch wieder darauf an, was das KI-System tut: Wie kritisch ist die Entscheidungs- oder Empfehlungsleistung, die dieses System bringt? Inwiefern berührt es die Bürger*innen und ihre Rechte? Das kann ich nicht verallgemeinern, weil der Begriff der künstlichen Intelligenz so groß und übergreifend ist, dass er oft den Diskurs schwieriger macht. Es ist leichter, über das einzelne System und eine bestimmte Anwendung zu sprechen.

In welchen Fällen ist der Einsatz von KI-Systemen kritisch?

Bestimmte Systeme agieren in einem sehr sensiblen Datenbereich. Man sollte sehr bewusst mit diesen Daten umgehen und sie wo möglich anonymisieren, um einen Bias zu vermeiden. Das gelingt nicht immer: Anonymisiert man beispielsweise die Herkunft, sind aber die Wohngebiete von Menschen erkennbar, können diese auch als Proxy dienen und Rückschlüsse erlauben. Bei gewissen Fragestellungen sollte man sich überlegen, ob es unsere Entscheidungsgrundlage besser macht, wenn wir eine KI einsetzen. Viele soziale Probleme sind nicht unbedingt Optimierungsprobleme. Brauchen wir wirklich ein Assistenzsystem oder eher ein menschliches Verfahren für bestimmte Entscheidungen?

Was wäre dafür ein Beispiel?

Worauf sollten Menschen in der Wissenschaftskommunikation achten, wenn sie über KI sprechen?

Es geht auch darum kritisch zu reflektieren: Den Anthropomorphismus, also den Drang, Technologie zu vermenschlichen – was ich gerade auch gemacht habe – müssen wir uns bewusst machen. Wir weisen KI durch unsere Sprache automatisch menschliche Eigenschaften und Fähigkeiten zu. Die Maschinen verwenden aber eine andere Logik, um zu Ergebnissen zu kommen, als das menschliche Denken, und neuronale Netze funktionieren auch nicht wie das menschliche Gehirn. Das sind lediglich Analogien, die oft herangezogen werden, um Dinge verständlicher zu machen oder Angst davor abzubauen. Dieser Automatismus ist allerdings problematisch. Unsere Sprache sollte zeigen, dass es trotzdem keine handelnde Person ist, sondern eben eine Maschine.