Sprachmodelle sind nicht so klug, wie Sie denken. Im Interview skizziert Katharina Anna Zweig, Keynote-Speakerin beim diesjährigen Forum Wissenschaftskommunikation*, welche zukünftigen Herausforderungen auf uns warten, wenn Maschinen zunehmend Informationen filtern.

Warum „die Maschine als Wissensquelle“ eine schlechte Idee ist

Viele Menschen erleben Chatbots heute als erstaunlich „wissend” und stellen den Sprachmodellen auch zu Wissenschaftsthemen Suchanfragen. Welche Folgen könnte das haben?

Grundsätzlich neigen diese Sprachmodelle dazu, unsere evolutionären Sensoren zu überlisten. Als Spezies waren wir erfolgreich, weil wir es geschafft haben, mithilfe von Sprache Kooperation zu ermöglichen. Wir sind noch nie auf etwas gestoßen, das Wörter so schön aneinanderhängen kann und gleichzeitig nicht intelligent ist. Daher fällt es uns Menschen schwer, diesen Maschinen nicht zu glauben.

In Ihrem neuen Buch „Weiß die KI, dass sie nichts weiß?“ äußern Sie die Vermutung, dass uns schlussendlich die Worte fehlen, um zu beschreiben, was Sprachmodelle überhaupt tun. Sehen Sie eine Möglichkeit für die Wissenschaftskommunikation, besser über dieses Thema zu kommunizieren?

Wichtig ist eine klare Terminologie. Ich spreche grundsätzlich nie von „der KI“, wenn ich Sprachmodelle meine. Bei anderen „KIs“ nenne ich die konkrete Aufgabenstellung, die sie bewältigen sollen, also etwa Bilderkennung, Text-to-Speech-Systeme oder Gesichtserkennung.

Insbesondere bei Sprachmodellen spreche ich oft von „dem Computer“ oder „der Maschine“, wodurch bereits eine gewisse Distanz entsteht. Wörter wie „antwortet“ oder „sagt“ vermeide ich ebenfalls und benutze stattdessen Formulierungen wie „generiert einen Text“.

In meinem Buch schlage ich vor, im Schriftlichen eine Tilde (Anmerkung der Redaktion: ~) vor den Text zu setzen, um zu zeigen, dass es sich um eine Annäherung an menschliches Verhalten handelt, die diesem zwar ähnelt, aber nicht menschlich ist.

Warum vermenschlichen viele diese Maschinen?

Ich denke, es liegt zum einen an der Unkenntnis der Technologie. Das ist logisch, schließlich hat niemand von uns darüber etwas in der Schule gelernt. Zum anderen ist es die Art, wie wir oder die Firmen über diese Technologie sprechen. Etwa OpenAI über ChatGPT 5.0 („thinks deeply when you need to“) oder Google Geminis „Thinking Budgets“. Das führt dazu, dass Nutzer*innen denken, dass es sich tatsächlich um Künstliche Intelligenz handelt, so wie wir sie seit Jahrzehnten aus Fernsehen, Serien und Kinofilmen kennen.

Was wünschen Sie sich – im Kontrast zu diesen Marketingbemühungen – wie Expert*innen über generative Modelle sprechen sollten?

Journalistische Texte sollten präziser sein. Ich wünsche mir, dass wir klar machen, dass es sich um Maschinen handelt. Dass es Software ist, die mit Methoden des maschinellen Lernens und der Statistik arbeitet. All diese Begriffe schaffen etwas mehr Distanz.

Ich hoffe auch, dass sich der Verbraucherschutz bald einmischt und festlegt, dass es unzulässig ist, damit zu werben, dass Sprachmodelle und Chatbots „denken“ können. Was ist das eigentlich für ein Versprechen? Auch in anderen Bereichen, zum Beispiel der Medizin, dürfen nicht ohne weiteres Heilsversprechen gemacht werden. Vielleicht sollte man das bei Chatbots ähnlich handhaben.

Gleichzeitig diskutiert die Wisskomm-Community darüber, wie man Sprachmodelle für sich nutzbar machen kann. Wie können Kommunikator*innen generative Tools verantwortungsvoll einsetzen?

Ich denke, dass sich Sprachmodelle nicht für eine Kommunikation eignen, bei der Verlässlichkeit erforderlich ist. Aus meiner Sicht kann man sich kaum Texte generieren lassen, ohne alles noch einmal sorgfältig nachzuprüfen. Dabei reicht es nicht aus, zu prüfen, ob das, was die Maschine generiert hat, stimmt. Man muss auch überlegen, ob sie etwas weggelassen hat, das hätte gesagt werden müssen.

Man überlässt der Maschine sonst zu schnell die Selektion dessen, was kommuniziert werden soll. Das reicht aus meiner Sicht für die Wissenschaftskommunikation nicht aus. Menschen haben – noch – kein Gespür dafür, wann die Maschine welchen Namen oder welche wissenschaftliche Perspektive einfügt, wie sie diese durch den generierten Text repräsentiert, und ob es nicht andere Stimmen gäbe, die man stattdessen zitieren müsste. Nimmt man diese Recherchearbeit auf sich, um für den Text Verantwortung übernehmen zu können, kann man den Text im Grunde genauso gut selbst erstellen.

In Ihrer kommenden Keynote auf dem Forum Wissenschaftskommunikation werden Sie unter anderem über einen verantwortungsvollen Technologietransfer sprechen. Wie könnte der aussehen?

Wenn neue Software oder Technologie eingeführt wird, verändert sich die Art und Weise, wie Menschen miteinander kommunizieren. Dieser Prozess muss begleitet werden. An der RPTU Kaiserslautern-Landau gibt es den deutschlandweit einzigartigen Studiengang Sozioinformatik. Wir bilden unsere Studierenden so aus, dass sie in sozioinformatischen Systemen denken. Diese bestehen aus Menschen, Institutionen und sozialen Regeln.

Sozioinformatiker*innen entwickeln Software, aber denken auch darüber nach, in welchem sozialen Zusammenhang die Software später eingesetzt wird. Ein soziales Problem kann beispielsweise sein: Wen wollen wir als Nächstes einstellen? Momentan gibt es viele Ideen, wie Maschinen dabei helfen könnten. Sozioinformatiker*innen würden technologieneutral prüfen, welche Methode sich dafür am besten eignet.

Sie haben in einem Interview gesagt, dass der Launch von rhetorisch überzeugenden Sprachmodellen im November 2022 Sie vollkommen überrascht habe. Welche weiteren Überraschungen stehen uns in der Weiterentwicklung dieser Technologie bevor?

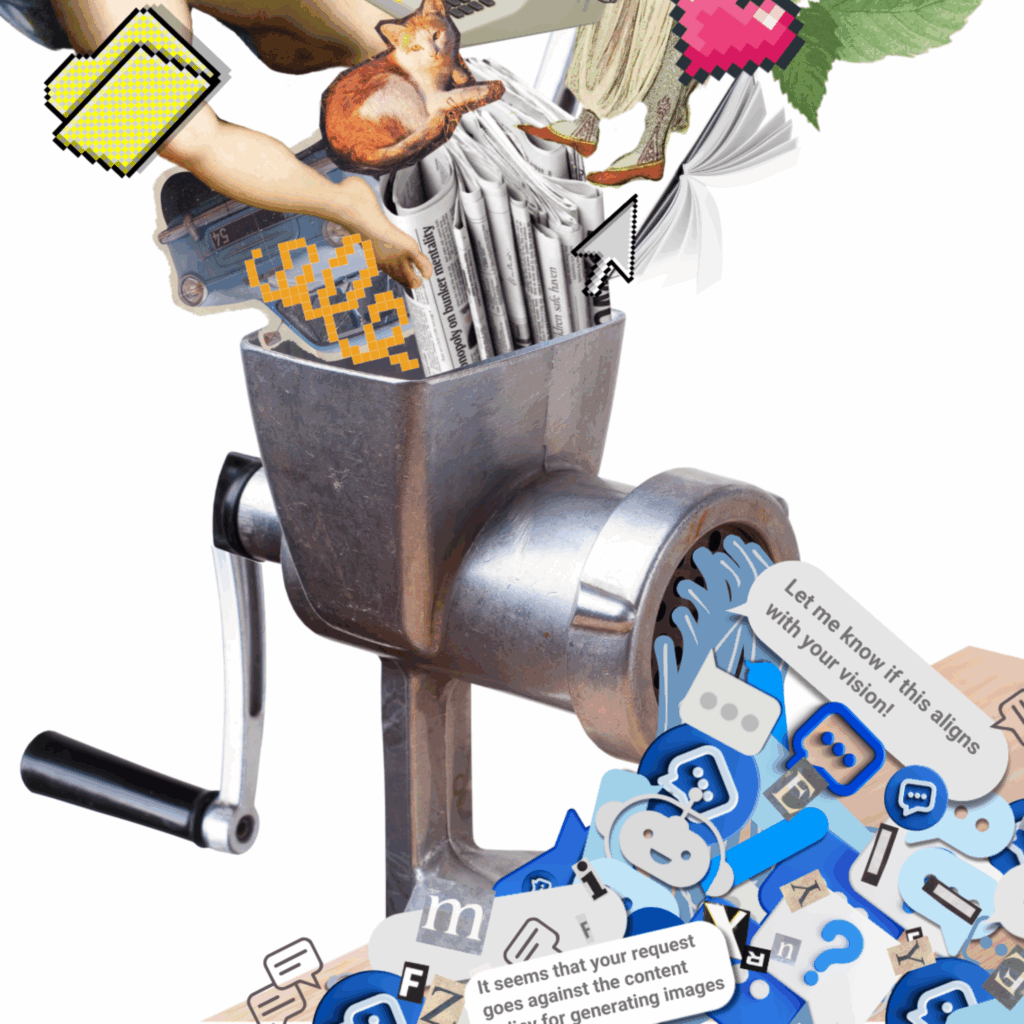

Es ist sehr schwierig geworden, im Internet noch gute Texte zu finden. Für Sprachmodelle steht also langfristig nicht mehr genügend Content zur Verfügung, der sicher und nachweisbar von Menschen erstellt wurde und dem aktuellen Sprachgebrauch entspricht. Erste Untersuchungen zeigen, dass die Qualität deutlich sinkt, wenn Sprachmodelle mit künstlich generierten Texten trainiert werden.

Ich vermute daher, dass die Qualität von Sprachmodellen langfristig sinken wird. Wahrscheinlich werden Menschen sogar irgendwann dafür bezahlt, Texte für Maschinen zu generieren, die dann wiederum andere Maschinen trainieren. Ob das gut oder schlecht ist, kann ich nicht genau sagen. Es ist eine merkwürdige Situation, in der Software ihren eigenen Fortbestand „vergiftet“.

Gibt es denn eine Entwicklung, die Sie sich wünschen würden?

Es wäre eine schöne Überraschung, wenn wir diese Technologie anders einsetzen könnten. Zum Beispiel: Ich würde gerne mit meinem Kalender sprechen können, um neue Termine einzutragen oder abzufragen, wann ich das letzte Mal in Stuttgart war. Das wäre eine enorme Erleichterung. Gleichzeitig würde man vermeiden, dass die Maschine als Wissensquelle missbraucht wird, weil sie dann einfach sagt: „Solange es nichts mit deinem Kalender zu tun hat, bin ich das falsche System.“

Die zweite Technologie, von der ich hoffe, dass wir sie viel häufiger sehen, ist die sogenannte RAG-Technologie (Retrieval Augmented Generation). Da geht es um echte Wissensdatenbanken, die mit Hilfe von natürlicher Sprache gezielt durchsucht werden können.

Das bedeutet, dass man große Zeitungsartikelarchive nicht mehr nur nach exakten Schlagwörtern, sondern auch nach Synonymen durchsuchen könnte. So könnte man alle Artikel über alleinerziehende Eltern finden, selbst wenn dieser Begriff nicht in ihnen auftaucht. Eine solche Technologie würde den verlässlichen Zugriff auf Informationen revolutionieren. Es gilt aber wie bei allen komplexen Softwaresystemen: Deutschland und Europa müssen diese Zukunft aktiv gestalten – sonst entscheiden andere über uns.

*Das Forum Wissenschaftskommunikation wird von Wissenschaft im Dialog (WiD) organisiert, einem der drei Träger des Portals Wissenschaftskommunikation.de. Der Schwerpunkt des Forums liegt 2025 auf „Algorithmen, Plattformen und KI: Wissenschaftskommunikation im digitalen Wandel“.