Ein Viertel der meistgeklickten TikTok-Suchergebnisse ist künstlich erzeugt. Oft ohne Kennzeichnung, oft täuschend echt. Welche Orientierung bleibt in dieser neuen Realität?

Wir versinken in Schrott

Im August 2025 bemerkte der AlgorithmWatch-Reporter Nicolas Kayser-Bril etwas Ungewöhnliches. Er fand sein Profil inklusive Bild und Biografie auf einer Seite, von der er noch nie etwas gehört hatte.

Es stellte sich heraus, dass es sich dabei um eine „AI Slop Farm“ handelte, die seine Identität gestohlen hatte. Die Artikel, die Kayser-Bril angeblich verfasst hatte, waren Beiträge über Astrologie und gefälschte Nachrichten. Er war Opfer von „Reputationsklau“ geworden, mit der künstlich erzeugte Seiten ihr algorithmisches Ranking verbessern wollen.

Auch die Kognitionswissenschaftlerin Iris van Rooij machte einen erstaunlichen Fund. Sie las eine Definition auf der Seite einer wissenschaftlichen Fachzeitschrift, die sie eindeutig als falsch einstufen konnte. Dann bemerkte sie: Die Definition war künstlich generiert worden.

Der YouTube-Kanal Kurzgesagt zeigt sich besorgt. In einem kürzlich veröffentlichten Video erklären sie, „AI Slop“ (zu Deutsch: KI-Schrott) zerstöre das Internet. YouTube erlebe derzeit einen Boom pseudowissenschaftlicher Kanäle, die täglich Hunderte Videos zu Geschichte, Biologie, Chemie, Physik oder Psychologie veröffentlichen.

Was ist ‘AI Slop’?

KI-Schrott ist ein „endlose[r] Strom billig produzierter, emotional aufgeladener KI-Inhalte, die digitale Räume fluten“1. Meist entstehen so fehlerhafte Inhalte, Videos und Bilder von geringer Qualität. Alternativ wird KI-Schrott auch als eine ‘invasive Art’, ‘Schmutz’, synthetisches Material wie ‘Polyester’ oder ‘hochverarbeitetes Junkfood’ beschrieben2.

Dahinter steckt die Motivation, möglichst viel emotionalisierenden Content möglichst billig zu produzieren, um Viralität zu erreichen. Je mehr Clicks erzielt werden, desto mehr Geld können die Produzent*innen des Slops potenziell über die Creator-Programme von Social Media Plattformen verdienen.

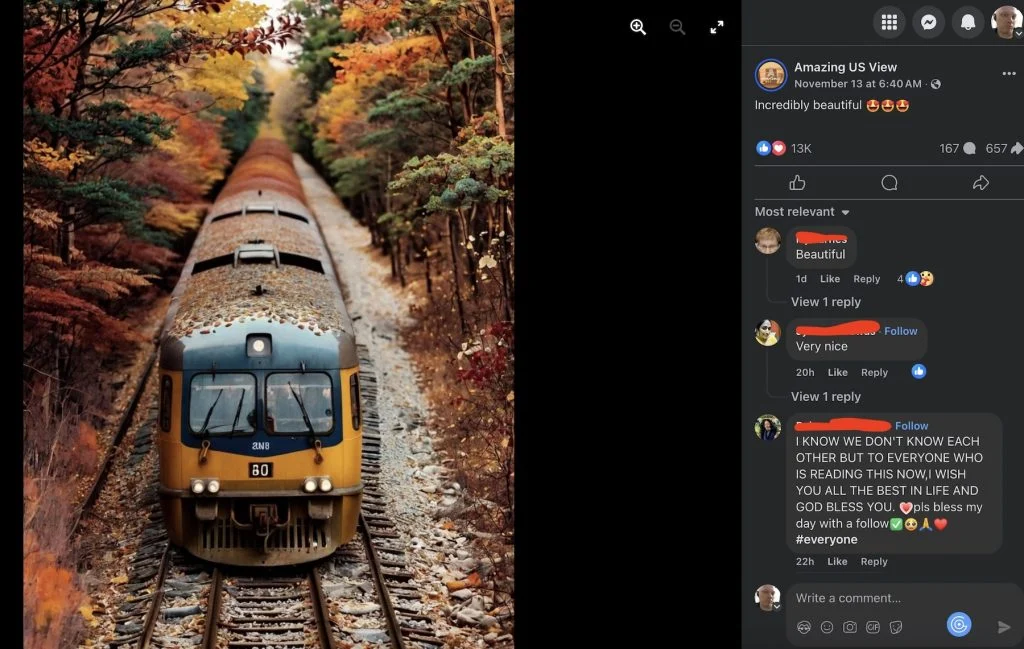

Häufig kombinieren die Inhalte fotorealistische Qualität mit unrealistischen Szenen. So entstehen schräge Bilder wie ‘Shrimp Jesus’, die eine Christusfigur bestehend aus Garnelen zeigen und millionenfach bei Facebook geliked und geteilt werden. Die Inhalte sind nicht per se als Fehlinformationen angelegt, sondern sollen in den meisten Fällen eher unterhalten oder Aufregung verursachen. Oft sind sie an aktuelle Ereignisse geknüpft. Durch die Masse und Schnelligkeit entsteht eine Informationserschöpfung, ein lautes digitales Grundrauschen.

Eine Untersuchung der europäischen Non-Profit Organisation AI Forensics zeigt, dass 25 Prozent von TikToks Top-Suchergebnissen synthetische Videos sind3. Die meisten dieser Videos hätten einen fotorealistischen Stil, der das Täuschungspotenzial erhöhe. Die Analyse von AI Forensics zeigt auch, dass die Plattformen die synthetischen Inhalte in den meisten Fällen nicht zuverlässig kennzeichnen. Laut Expert*innen sei es immer schwieriger, künstlich generierte Inhalte durch optische Unregelmäßigkeiten zu identifizieren.

Eine Wired Recherche ergibt, dass auch LinkedIn betroffen ist. Über die Hälfte der untersuchten Posts seien mit Sprachmodellen verfasst worden4. Eine SEO-Firma ist zu demselben Ergebnis gekommen, nachdem sie Online-Artikel untersucht hatte5. Sie fand heraus, dass seit dem Launch von ChatGPT im November 2022 die Zahl künstlich generierter Beiträge rapide gestiegen war und sie nun erstmals die von Menschen verfassten überstieg.

Weniger Reichweite für seriösen Content

Auch wenn der KI-Schrott auf den ersten Blick harmlos oder lächerlich wirkt, drohen ernsthafte Konsequenzen.

Der Reporter von AlgorithmWatch, Kayser-Bril, spekuliert, dass insbesondere Journalist*innen und Wissenschaftler*innen künftig von Reputationsklau bedroht sein könnten. Die Kognitionswissenschaftlerin van Rooij vermutet, dass fehlerhafte Inhalte in Fachzeitschriften für Expert*innen leicht, für die Öffentlichkeit jedoch nicht so einfach zu identifizieren sind. Schließlich nehme man bei Fachzeitschriften eine gewisse Seriosität an.

YouTube-Creator*innen berichten von einem Einbruch ihrer Zugriffszahlen, seit die Flut der künstlich generierten, pseudowissenschaftlichen Videos zunimmt. Besonders perfide ist, dass über mehrere Ecken synthetische Informationen zu echten werden. So ist ein Chatbot mittlerweile davon überzeugt, dass Kayser-Bril für die bulgarische Content-Farm arbeitet, die seine Identität gestohlen hat.

Durch Slop brechen Infrastrukturen zusammen

Ein weiteres Problem ist, dass Infrastrukturen derart mit Schrott überflutet werden, dass sie nicht mehr funktionieren. Das Moderationsnetzwerk von Wikipedia ächzt unter dem Anstieg qualitativ schlechter Beiträge6. Der Preprint-Server arXiv Computer Science hat den automatischen Upload von Übersichtsartikeln und Positionspapieren vorerst gestoppt7. Die freiwilligen Moderator*innen hätten keine Kapazitäten, den „unüberschaubaren Zustrom“ von Artikeln zu bewältigen. Währenddessen sinkt die Informationsqualität von Online-Inhalten immer weiter.

Die Praxis, Sprachmodelle mit synthetischen Texten aufzubauen, könnte letztlich zu einem „Model Collapse“ führen, das heißt, es würde immer schlechterer Output produziert. Der Wissenschafts-YouTuber Simon Clark warnt davor, dass dieses „Slop-on-Slop-Training“ unser kollektives Wissen nachhaltig vergiften könnte8.

Er beobachtet, dass Klimaskeptiker*innen den schnell produzierten „Slop“ dazu nutzen, Sprachmodelle bewusst mit Falschinformationen zu unterwandern (sogenanntes „LLM Grooming“). Aufgrund der großen Menge verbreiten sich diese Fehlinformationen rasend schnell im Internet und werden sogar auf legitimen Nachrichtenseiten als Fakten präsentiert.

Das Zombie-Internet nervt

Manche Beobachter*innen argumentieren, Social-Media-Plattformen und das Internet würden „sterben“ oder „zerstört“ werden. Damit wird auf die satirische Verschwörungstheorie des „Dead Internets“ angespielt. In dieser Erzählung wird das Internet nur noch von Maschinen bewohnt, die sich ohne menschlichen Einfluss gegenseitig beschimpfen und immer weiter im Kreis drehen.

Mario Sixtus, der einen Dokumentarfilm über dieses Phänomen gedreht hat, schreibt, das Internet sei noch nicht ganz tot: „Vielmehr bin ich davon überzeugt, dass wir derzeit eine Art Zombie-Internet erleben, eine lebendig-tot-untote Zwischenwelt des Übergangs.“9

Der Atlantic beschreibt dieses Gefühl als eine „Infrastruktur der Bedeutungs- und Orientierungslosigkeit“. Online beobachte man, dass User*innen auch gegenüber real produziertem Content misstrauisch sind. Es gibt erste empirische Belege dafür, dass Personen, die Chatbots zum Schreiben nutzen, von ihren Kolleg*innen als weniger kreativ und weniger vertrauenswürdig wahrgenommen werden. Viele sind von den immer gleich aussehenden Bildern genervt.

Was sich mit ‚Sora‘ jetzt ändert

OpenAI, die Firma hinter ChatGPT, hat gerade eine neue soziale Plattform vorgestellt. Mit Sora können Nutzer*innen ihr eigenes Gesicht scannen und sich durch einen simplen Prompt in alle möglichen fiktiven Szenen einfügen. Es ist eine Art künstliches TikTok. Man könnte sich beispielsweise einen fiktiven Professor erstellen lassen, der einem geduldig Chemie erklärt. Solche Erklärvideos werden mit dem Update des Videogenerators länger und sehen qualitativ hochwertiger aus.

Die kostenlose App ist vorerst nur auf Einladung und in den USA verfügbar. Dennoch sind die Videos bereits auf allen anderen Social-Media-Feeds aufgetaucht. Zu sehen sind Influencer*innen, die sich einen Oscar oder den Nobelpreis überreichen lassen, sowie hyperrealistische Videos von Tieren, die auf den Straßen von New York Musik machen.

Interessanterweise hat YouTube selbst nun eine Funktion erhalten, mit der Creator*innen Videos generieren lassen können. Ein amerikanischer Blogger machte besorgt darauf aufmerksam, dass das Sora-Wasserzeichen immer nur am Rand und nie in der Mitte erscheint und sich somit relativ einfach herausschneiden lässt10.

Eine Herausforderung für die Kommunikation

Das Problem falscher oder irreführender Informationen im digitalen Raum gibt es schon lange. „Es ist nur so, dass Nutzer*innen nun die Fähigkeit haben, diese Inhalte sehr schnell und kostengünstig zu produzieren, und dass es einfach viel mehr davon gibt“, sagt Natalia Stanusch, Co-Autorin der Studie von AI Forensics. Die Tendenz, dass Menschen vorsichtiger werden, wenn sie Inhalte online sehen, findet sie positiv. Es sei sehr wichtig, diese kritische Medienkompetenz weiter zu stärken.

Ihr Co-Autor Martin Degeling ergänzt: „Ich denke, das Einzige, worauf wir uns im Moment noch verlassen können, ist das Vertrauen, das Forschende und Kommunikator*innen über die Zeit hinweg aufgebaut haben.“ KI-Schrott könne man nämlich daran erkennen, dass ein Profil plötzlich auftaucht und über kurze Zeit hinweg sehr viel Content produziert. Hilfreich sind zudem Tools, die entwickelt werden, um beispielsweise Slop in Zitationslisten automatisch zu identifizieren.

Stanusch und Degeling gehen nicht davon aus, dass das Internet als Wissensquelle unwiederbringlich verloren ist.

„Es ist definitiv eine sehr, sehr herausfordernde Zeit. Gleichzeitig versuche ich, optimistisch zu sein. Ich glaube, dass es ein immer stärkeres Bewusstsein dafür gibt, dass das, wohin wir derzeit steuern, nicht unbedingt das ist, was wir wollen. Das ist nicht die Art von Internet, in dem wir uns bewegen und in dem wir Informationen teilen möchten“, sagt Stanusch.

Beide betonen, wie wichtig es ist, dass die Technologie der unsichtbaren Wasserzeichen entwickelt und durchgesetzt wird und große Plattformen durch Regulierung zu besseren Maßnahmen gegen den Slop gezwungen werden.

- Deutsche Welle: Gegen den Bullsh*: KI-Schrott und Medienkompetenz ↩︎

- The Atlantic: A Tool That Crushes Creativity ↩︎

- AI Forensics: AI Generated Algorithmic Virality ↩︎

- Wired: Yes, That Viral LinkedIn Post You Read Was Probably AI-Generated ↩︎

- Axios: Exclusive: AI writing hasn’t overwhelmed the web yet ↩︎

- The Verge: How Wikipedia is fighting AI slop content ↩︎

- Heise: arXiv ändert Regeln – KI-Studien zwischen Pre-Prints ↩︎

- Simon Clark: Science Communication in the Age of AI Slop | Cambridge Union ↩︎

- Die Zeit: Da ist aber was los im Zombie-Internet ↩︎

- Hank Green: Give me a single reason why Sora2 should exist. ↩︎